Hoe AI-modellen te testen: De enige gids die je nodig hebt (2025)

Leer hoe je AI-modellen zoals ChatGPT, Claude en Gemini test met ons 6-stappen framework. Vergelijk AI-modellen naast elkaar met echte taken—geen technische vaardigheden vereist.

Hoe AI-modellen te testen: De enige gids die je echt nodig hebt

Ik begon ongeveer een jaar geleden obsessief AI-modellen te testen toen ik Zemith bouwde. Niet omdat ik een ML-onderzoeker ben—dat ben ik niet. Maar omdat ik steeds verbrand werd door de hype.

Iedereen zei dat GPT-4 het beste was. Toen kwam Claude uit en mensen zeiden dat dat het beste was. Toen Gemini. Dan zou er een nieuw model verschijnen en plotseling was dat de koning. De doelpalen bleven verschuiven, en ik realiseerde me: als je wilt weten welk AI-model daadwerkelijk werkt voor jouw behoeften, moet je AI-modellen zelf testen.

Geen benchmarks lezen. Geen marketingclaims vertrouwen. Ze daadwerkelijk testen.

Dit is geen technische gids over perplexity-scores of BLEU-metrics. Dit is hoe echte mensen—oprichters, makers, ontwikkelaars, iedereen die dagelijks AI gebruikt—AI-modellen moeten evalueren en uitzoeken welke werkt.

Hoewel sommige mensen liever naar grafieken kijken voor vergelijking, verschilt het werkelijke resultaat in de echte wereld vaak sterk. De enige manier om zeker te weten wat en hoe het modelantwoord is, is door daadwerkelijk gebruik te testen.

LLM Chart

Waarom AI-modellen zelf testen niet onderhandelbaar is

Dit is wat ik op de harde manier heb geleerd: AI-model benchmarks zijn in principe nutteloos voor je echte werk.

Een model kan een academische test domineren, maar dat vertelt je niet of het e-mails in jouw stem zal schrijven, de jargon van jouw industrie zal begrijpen, of de vreemde edge cases zal aanpakken waar je bedrijf elke dag mee te maken heeft.

Ik lees al maanden Reddit-discussies over AI-modellen, en er is dit terugkerende thema: iemand vraagt "welke AI moet ik gebruiken?" en de antwoorden zijn overal. De ene persoon zweert dat Claude onverslaanbaar is voor coderen. Een ander zegt dat ChatGPT creatiever is. Iemand anders houdt vol dat Gemini het meest accuraat is. Ze hebben allemaal gelijk en ze hebben allemaal ongelijk.

Na het testen van deze modellen duizenden keren, hier is de waarheid: er is geen enkel "beste" AI-model. Elk heeft verschillende sterke punten, en die sterke punten zijn verschillend belangrijk afhankelijk van wat je daadwerkelijk probeert te doen.

ChatGPT kan je creatieve, boeiende content geven die menselijk aanvoelt. Claude kan meer gestructureerde, doordachte antwoorden geven die perfect zijn voor analyse. Gemini blinkt uit in feitelijk onderzoek en heeft een enorm contextvenster voor lange documenten.

De enige manier om te weten welk model het beste voor je werkt, is om AI-modellen te testen met je echte use cases. Niet hypothetische. Niet generieke prompts. Je echte werk.

De vragen die iedereen echt stelt

Voordat we ingaan op hoe je AI-modellen test, laat me de vragen aanpakken die ik constant zie op Reddit en in DM's:

"Kan ik gewoon ChatGPT voor alles gebruiken?"

Je zou kunnen, maar je laat veel liggen. Het is alsof je een Zwitsers zakmes gebruikt wanneer je soms echt een goede schroevendraaier nodig hebt.

"Zijn de benchmarks niet genoeg?"

Niet echt. Ik zag een Reddit-draad waar iemand opmerkte dat Claude lager scoorde op een benchmark maar hen veel betere code-uitleg gaf. Benchmarks meten wat onderzoekers belangrijk vinden, niet wat je daadwerkelijk helpt om werk gedaan te krijgen.

"Hoe weet ik zelfs of het ene antwoord beter is dan het andere?"

Dit is de echte vraag, en eerlijk gezegd, het is eenvoudiger dan je denkt. Als je het antwoord kunt gebruiken om je taak beter, sneller of met minder frustratie te voltooien—dat is je antwoord.

"Is dit niet gewoon te veel nadenken?"

Misschien, als je AI casual gebruikt. Maar als je een bedrijf bouwt, dagelijks content schrijft, of vertrouwt op AI voor echt werk? Testen is niet te veel nadenken—het is due diligence.

Hoe AI-modellen te testen: Het 6-stappen framework

Vergeet technische metrics. Hier is hoe je taalmodellen daadwerkelijk test en AI-modellen vergelijkt op een manier die ertoe doet:

Infographic showing 6-step framework for testing AI models with icons for each step

1. Begin met je echte taken

Test AI-modellen niet met generieke prompts zoals "schrijf een verhaal over een kat." Dat is nutteloos.

Pak in plaats daarvan drie tot vijf taken die je daadwerkelijk regelmatig doet:

- Schrijf een concept van een specifiek type e-mail dat je vaak verstuurt

- Vat een typisch document van je werk samen

- Genereer ideeën voor je echte projecten

- Schrijf code voor iets dat je daadwerkelijk bouwt

- Beantwoord een klantenservicevraag die je hebt ontvangen

Hoe specifieker en echter deze taken zijn, hoe beter je AI-model evaluatie zal zijn.

2. Gebruik identieke prompts over verschillende AI-modellen

Dit is cruciaal wanneer je AI-modellen test. Neem exact dezelfde prompt en voer deze uit via ChatGPT, Claude, Gemini en welke andere modellen je ook overweegt.

Verander de formulering niet. Pas het niet aan voor elk model. Gebruik identieke inputs zodat je de outputs eerlijk kunt vergelijken.

Toen ik dit voor het eerst deed bij Zemith, was ik geschokt. Voor creatieve brainstorming gaf ChatGPT me consequent interessantere invalshoeken. Voor het analyseren van data of het opbreken van complexe onderwerpen was Claude duidelijker en georganiseerder. Voor feitelijk onderzoek met actuele informatie kwam Gemini voorop.

Ik zag een geweldige Reddit-post waar iemand alle drie de modellen testte met dezelfde raadsel: "Hoe is het mogelijk dat de vader van de zoon van een dokter geen dokter is?" Alle drie hadden gelijk, maar hun benaderingen waren volledig verschillend. Claude gaf de meest gedetailleerde uitsplitsing en wees zelfs op potentiële vooroordelen in hoe we over het probleem denken. ChatGPT was beknopt en to the point. Gemini gaf het juiste antwoord met een korte uitleg.

Allemaal correct, allemaal nuttig, maar elk met een andere stijl. Dat verschil doet ertoe wanneer je beslist welke je voor je echte werk gebruikt.

3. Vergelijk naast elkaar, niet uit het geheugen

Het menselijk geheugen is verschrikkelijk bij vergelijkingen. Als je vandaag ChatGPT test en morgen Claude, vergeet je de nuances van wat elk zei.

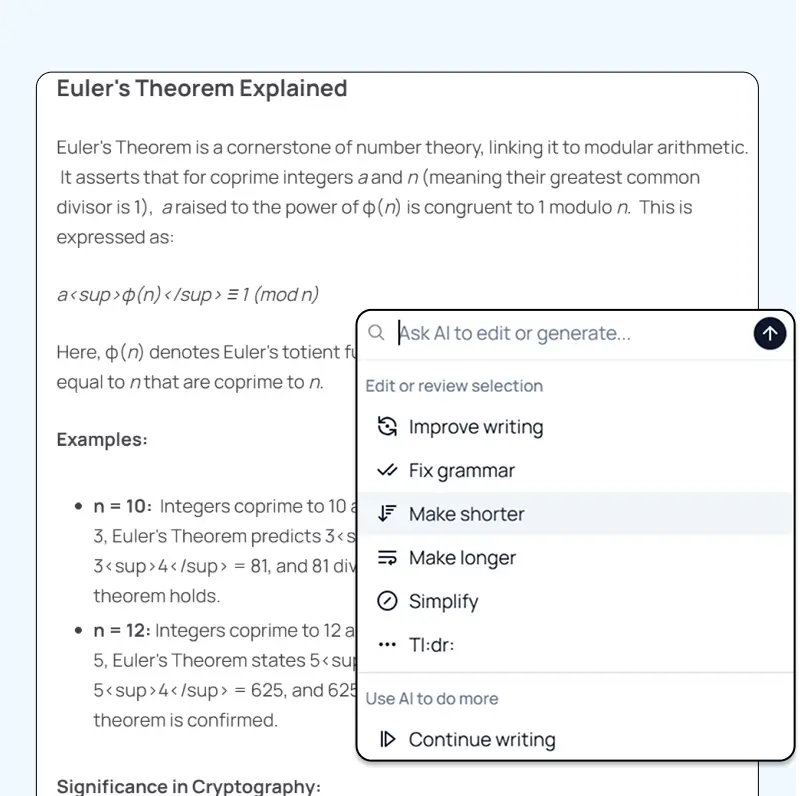

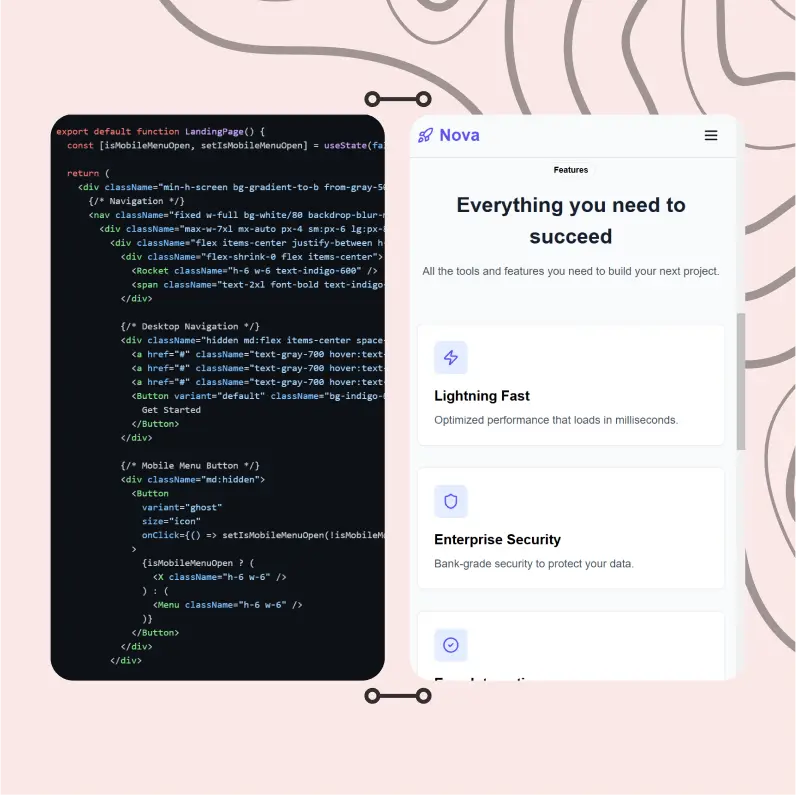

Dit is precies waarom ik FocusOS op Zemith bouwde, omdat proberen te onthouden welk model wat zei over meerdere tabbladen een nachtmerrie is.

Screenshot showing side-by-side AI model comparison interface with multiple responses visible at once

Bij Zemith heb ik Focus OS ontworpen met een Chrome-achtig tabbladsysteem zodat je snel tussen tabbladen kunt wisselen zonder context van één pagina te verliezen zonder met browsertabbladen te jongleren, zonder het spoor te verliezen van welk antwoord van welk model kwam.

Samen naar antwoorden kijken onthult patronen die je anders zou missen:

- Welk model beantwoordt daadwerkelijk je vraag versus welke dwaalt af?

- Welke behoudt je voorkeurstoon?

- Welke geeft je informatie die je daadwerkelijk kunt gebruiken?

Dit is de beste manier om AI-modellen te testen omdat je de verschillen in real-time ziet, niet probeert ze uit het geheugen te reconstrueren.

4. Test op consistentie en AI-model prestaties

Voer dezelfde prompt een paar keer door elk model. AI-modellen zijn probabilistisch—ze geven niet altijd hetzelfde antwoord.

Sommige modellen zijn consistenter dan andere. Als je AI gebruikt voor productiewerk of klantgerichte content, doet consistentie ertoe. Je wilt niet dat het ene antwoord briljant is en het volgende middelmatig.

Wanneer je AI-modellen evalueert, is consistentie een belangrijke metric die benchmarks niet goed vastleggen.

5. Controleer op hallucinaties en nauwkeurigheid

Dit is vooral belangrijk als je AI gebruikt voor iets feitelijks.

AI-modellen verzinnen soms dingen met vertrouwen. Ze citeren studies die niet bestaan, verwijzen naar functies die producten niet hebben, of stellen "feiten" die volledig verkeerd zijn.

Test dit door vragen te stellen waar je het juiste antwoord weet, of door het model te vragen bronnen te citeren. Verifieer dan dat die bronnen daadwerkelijk bestaan en zeggen wat het model beweert.

In mijn ervaring met het testen van taalmodellen verschillen ze hier aanzienlijk. Sommige zijn vatbaarder voor zelfverzekerde hallucinaties dan andere, en je moet weten welke je kunt vertrouwen voor feitelijk werk.

6. Documenteer je resultaten

Houd notities bij van wat goed werkte en wat niet. Je toekomstige zelf zal je bedanken. Je kunt de notities ook binnen Zemith note opslaan, door naar de notitiepagina te gaan of gewoon een nieuw notitietabblad binnen FocusOS opnieuw te openen

Ik houd een eenvoudige spreadsheet bij:

- Taaktype

- Welke modellen ik heb getest

- Winnaar en waarom

- Opvallende verschillen

Na een paar weken AI-modellen op deze manier testen, ontstaan er patronen. Je zult beginnen te zien welk model consistent wint voor welk type taak.

Waarop te letten bij het vergelijken van AI-modellen

Wanneer je naar antwoorden van drie verschillende modellen staart, is dit wat er echt toe doet voor je AI-model evaluatie:

Antwoordkwaliteit: Beantwoordt het daadwerkelijk wat je vroeg? Is de informatie accuraat? Is het compleet, of miste het belangrijke aspecten?

Toon en stijl: Komt het overeen met hoe je wilt klinken? Sommige modellen zijn formeler, andere casualer. Ik heb gemerkt dat Claude de neiging heeft om meer afgemeten en doordacht te zijn. ChatGPT kan dynamischer en gespreksvoller zijn. Een Reddit-gebruiker zei dat ChatGPT "meer boeiend en sympathiek" is geworden, maar waarschuwde dat het het een "geavanceerde ja-man" maakt die overal mee instemt. Als je echte kritiek nodig hebt, moet je er expliciet om vragen.

Diepte versus beknoptheid: Heb je uitgebreide uitleg nodig of beknopte antwoorden? Verschillende modellen standaard naar verschillende detailniveaus. Ik testte dezelfde prompt over alle drie—ChatGPT gaf me het meest beknopte antwoord dat je in één oogopslag kon lezen, Claude gaf stap-voor-stap instructies, en Gemini gaf een overzicht zonder stappen.

Creativiteit versus nauwkeurigheid: Voor creatieve taken wil je misschien onverwachte ideeën. Voor analytisch werk wil je precisie. Modellen geoptimaliseerd voor het ene worstelen vaak met het andere.

Snelheid: Als je AI interactief gebruikt, doet responstijd ertoe. Wanneer ik AI-modellen test, varieert de snelheid aanzienlijk tussen modellen en zelfs tussen verschillende versies van hetzelfde model.

Citeert het daadwerkelijk bronnen?: Dit is enorm als je onderzoek doet. Gemini is consequent beter in het verstrekken van links naar echte bronnen. ChatGPT geeft je soms verouderde info (het weet alleen tot eind 2023 in de gratis versie). Claude is historisch niet geweldig geweest in het linken naar bronnen, wat frustrerend is wanneer je iets moet verifiëren.

AI-model vergelijking: Wat ik heb geleerd door duizenden prompts te testen

Hier zijn de patronen die ik heb opgemerkt bij het vergelijken van AI-modellen voor verschillende use cases:

Voor schrijven en contentcreatie

ChatGPT blinkt uit in creatieve, boeiende content. Het is geweldig voor blogposts, marketingteksten en alles wat persoonlijkheid nodig heeft. Een gebruiker die Twitter-hooks testte zei "geen van hen is geweldig" maar Claude gaf het beste resultaat—niet te breedsprakig, geen onnodige hashtags.

Claude is beter wanneer je doordacht, genuanceerd schrijven nodig hebt of een specifieke stijl nauwkeurig wilt matchen. Ik gebruik het om mijn schrijven te bewerken, vooral wanneer ik het eerst voorbeelden van mijn beste werk geef.

Voor coderen

Hier wordt het interessant wanneer je AI-modellen head-to-head test.

In tests die ik heb gezien, toen gevraagd om "een volledig functioneel Tetris-spel te maken", bouwde Claude een prachtig, volledig functioneel spel met scores en controles. ChatGPT creëerde iets basics dat werkt. Gemini deed het goed maar was niet helemaal op het niveau van Claude.

Echter, Claude Sonnet kost 20x meer dan Gemini Flash. Als je een AI-product bouwt waar kosten ertoe doen, is Gemini misschien de slimmere keuze. Claude produceert echter consequent schonere code met betere documentatie voor complexe taken.

Voor onderzoek en samenvatting

Gemini blinkt uit met zijn enorme contextvenster en heeft de neiging om feitelijker accuraat te zijn. Het kan enorme documenten verteren en efficiënt belangrijke informatie eruit halen.

Een recensent die alle drie testte vond Gemini "de meest consistente allrounder" en bijzonder sterk met feitelijke, contextuele queries. Het heeft ook daadwerkelijke webzoekfunctie ingebouwd, in tegenstelling tot Claude.

Voor redeneren en probleemoplossing

De redeneermodellen (zoals OpenAI's o1) breken complexe problemen systematisch af. Ze zijn uitstekend voor planning, strategie en multi-stap denken. Maar ze zijn langzamer—soms duurt het minuten om te reageren.

Voor analyse en uitleg

Claude biedt gestructureerde, logische analyse wanneer je AI-modellen voor dit doel evalueert. Het is bijzonder goed in het afbreken van complexe ideeën en ze duidelijk uitleggen. Verschillende Reddit-gebruikers noemden dat Claude geweldig is voor "doordachte, gebalanceerde argumenten", vooral over controversiële onderwerpen.

De geheugenfactor

Hier is iets dat me verraste bij het testen van taalmodellen—in 2025 heeft alleen ChatGPT geheugen. Het onthoudt details over je over gesprekken heen. Gemini en Claude niet.

Als je een AI nodig hebt die je voorkeuren, je projecten, je schrijfstijl van sessie tot sessie onthoudt, is ChatGPT momenteel je enige optie. Ik vind dit wild omdat het deze "magische momenten" creëert waar ChatGPT dingen voorstelt op basis van eerdere gesprekken.

ChatGPT vs Claude vs Gemini: Snelle vergelijking

| Functie | ChatGPT | Claude | Gemini |

|---|---|---|---|

| Beste voor | Creatieve content, algemene taken | Code, analyse, bewerking | Onderzoek, lange documenten |

| Sterke punten | Boeiende toon, geheugen | Gestructureerd denken, schone code | Feitelijke nauwkeurigheid, context |

| Zwakke punten | Kan een "ja-man" zijn | Geen geheugen, minder bronnen | Minder creatief |

| Contextvenster | 128K tokens | 200K tokens | 1M tokens |

| Webzoeken | Met plugins | Ingebouwd | Ingebouwd |

| Kosten | Midden | Hoogste | Laagste (Flash) |

| Snelheid | Snel | Snel | Varieert |

Maar hier is het belangrijkste inzicht: jouw resultaat zal variëren. Wat werkt voor mijn use cases werkt misschien niet voor de jouwe. Daarom moet je AI-modellen testen met je eigen prompts.

Hieronder staat de grafiek van frontier LLM ter referentie evenals de intelligentie-index

llm-frontier-intelligence-index

Tools om AI-modellen te testen

De gemakkelijkste manier om verschillende AI-modellen te testen is ze naast elkaar te gebruiken. Hier zijn je opties:

Optie 1: Meerdere tabbladen openen - Gratis maar vervelend. Kopieer-plak je prompt in ChatGPT, Claude en Gemini in aparte tabbladen. Vergelijk handmatig.

Optie 2: Gebruik Zemith's Focus OS - Dit is wat ik specifiek voor dit probleem heb gebouwd. Gebruik verschillende modellen binnen onze FocusOS-tabbladen, zie resultaten naast elkaar met ons Chrome-achtige tabbladsysteem. Je kunt snel tussen modelantwoorden wisselen zonder context te verliezen of met vensters te jongleren. Bespaart tijd en maakt vergelijking duidelijk.

Optie 3: API-toegang - Als je technisch bent, kun je scripts schrijven om AI-modellen programmatisch te testen. Goed voor bulk testen maar vereist programmeerkennis.

Optie 4: Andere vergelijkingstools - Er zijn een paar andere platforms zoals Poe of nat.dev die je modellen laten vergelijken, hoewel functies variëren.

De sleutel is een systematische manier hebben om AI-modellen te vergelijken, niet gewoon willekeurig tussen hen springen. Zemith's Focus OS maakt dit heel eenvoudig met zijn tabblad-gebaseerde interface—denk aan Chrome-tabbladen, maar elk tabblad is een ander AI-model antwoord op je prompt.

Veelgemaakte fouten bij het testen van AI-modellen

Ik heb al deze fouten gemaakt. Leer van mijn pijn:

Fout 1: Testen met verschillende prompts - Je verandert de formulering licht voor elk model en vraagt je dan af waarom resultaten verschillen. Gebruik identieke prompts.

Fout 2: Slechts één keer testen - Je voert één test uit en verklaart een winnaar. AI-modellen hebben variabiliteit. Test meerdere keren.

Fout 3: Kosten negeren - Je vindt het "beste" model maar het kost 20x meer. Voor productiegebruik doet kosten per token ertoe.

Fout 4: Edge cases niet testen - Alles werkt geweldig met eenvoudige prompts, dan breekt je echte use case alles. Test de rare dingen.

Fout 5: Vertrouwen op subjectief "gevoel" - Je houdt van de persoonlijkheid van één model dus je gebruikt het voor alles. Dat is prima voor casual gebruik, verschrikkelijk voor zakelijke beslissingen.

Fout 6: Resultaten niet documenteren - Je test grondig maar schrijft niets op. Drie weken later kun je niet onthouden welk model beter was voor wat.

Hoe lang duurt het om AI-modellen te testen?

Eerlijk? Ongeveer een week echt gebruik geeft je 80% van wat je moet weten.

Hier is wat ik aanbeveel:

- Dag 1-2: Test je top 3-5 taken over alle modellen. Documenteer winnaars.

- Dag 3-5: Gebruik je "winnaar" voor elk taaktype in echt werk. Noteer eventuele problemen.

- Dag 6-7: Test alles opnieuw dat niet werkte zoals verwacht. Pas je keuzes aan.

Daarna heb je een solide gevoel van welk model je wanneer moet gebruiken. Je blijft leren in de loop van de tijd, maar de initiële investering is slechts een week aandacht.

De beste manier om AI-modellen te testen is niet een maand besteden aan formele evaluatie. Het is opzettelijk zijn over testen tijdens je normale werk voor een korte periode.

De multi-model benadering

Dit is wat ik nu echt doe, en wat ik aanbeveel nadat je AI-modellen hebt getest:

Probeer niet één "beste" model te kiezen. Gebruik verschillende modellen voor verschillende taken.

Ik gebruik ChatGPT voor brainstorming en eerste concepten van creatieve content. Ik gebruik Claude wanneer ik zorgvuldige analyse of bewerking nodig heb. Ik gebruik Gemini bij het werken met grote documenten of wanneer ik actuele informatie van het web nodig heb.

Dit is waarom ik Zemith heb gebouwd om meerdere modellen te ondersteunen. De toekomst gaat niet over het vinden van de ene perfecte AI—het gaat over het hebben van het juiste gereedschap voor elke klus.

Denk eraan als het hebben van verschillende apps op je telefoon. Je gebruikt Instagram niet voor e-mail of Gmail voor foto's. Verschillende tools voor verschillende doeleinden.

Wanneer je AI-modellen correct vergelijkt en evalueert, realiseer je je dat specialisatie generalisatie verslaat.

Praktische tips om AI-modellen effectief te testen

Begin klein: Probeer niet alles tegelijk te testen. Kies drie veelvoorkomende taken en test die eerst grondig.

Wees specifiek: Vage prompts geven vage resultaten. Test met de echte, specifieke prompts die je in echt werk zult gebruiken.

Test edge cases: Test niet alleen het happy path. Probeer prompts die ambigu, complex of ongebruikelijk zijn. Daar zie je echte verschillen in AI-model prestaties.

Overweeg kosten: Sommige modellen zijn duurder dan andere. Als je hoogvolume werk doet, houd rekening met prijzen bij het evalueren van AI-modellen. Een iets slechter model dat 10x minder kost, kan de betere keuze zijn.

Itereer je prompts: Soms is wat lijkt op een modelzwakte eigenlijk een promptprobleem. Als resultaten niet goed zijn op welk model dan ook, herzie je prompt.

Blijf bijgewerkt: Modellen verbeteren constant. Wat vandaag waar is, kan volgende maand veranderen. Test periodiek opnieuw met belangrijke use cases. De beste manier om AI-modellen te testen omvat regelmatige herbeoordeling.

Deel je bevindingen: Sluit je aan bij gemeenschappen waar mensen discussiëren over het testen van taalmodellen. Je leert van de ervaringen van anderen en ontdekt use cases die je niet had overwogen.

FAQ: AI-modellen testen

Heb ik technische vaardigheden nodig om AI-modellen te testen?

Nee. Als je tekst kunt kopiëren-plakken, kun je AI-modellen testen. De aanpak die ik heb geschetst vereist nul programmeren of technische kennis.

Wat is de beste gratis manier om AI-modellen te testen?

Open gratis accounts voor ChatGPT, Claude en Gemini. Gebruik meerdere tabbladen. Het is onhandig maar werkt. De meeste modellen hebben gratis niveaus die goed genoeg zijn voor testen.

Hoe vaak moet ik AI-modellen testen?

Doe een grondige evaluatie wanneer je voor het eerst AI voor werk begint te gebruiken. Test dan elke 3-4 maanden opnieuw naarmate modellen verbeteren. Test ook wanneer nieuwe belangrijke modellen worden gelanceerd.

Kan ik AI-model benchmarks helemaal vertrouwen?

Ze zijn niet nutteloos, alleen beperkt. Benchmarks vertellen je theoretische capaciteiten. Je testen vertelt je praktische prestaties voor je specifieke behoeften. Gebruik beide.

Moet ik AI-modellen voor elke taak testen?

Nee. Test je meest voorkomende taken en je belangrijkste taken. Je ontwikkelt snel intuïtie voor welk model je voor variaties moet gebruiken.

Wat als het "beste" model te duur is?

Dan is het niet echt het beste model voor jou. Het beste model is degene die je goede genoeg resultaten geeft tegen een prijs die zinvol is voor je use case.

De bottom line over hoe AI-modellen te testen

AI-modellen testen hoeft niet ingewikkeld te zijn. Je hebt geen technische expertise of fancy evaluatieframeworks nodig.

Je hoeft alleen de modellen te gebruiken met je echte taken, de resultaten naast elkaar te vergelijken en aandacht te besteden aan wat werkt.

Ik zag iemand op Reddit hun testproces perfect beschrijven: "Ik spring tussen AI-tools als een cafeïne-aangedreven flipperkast. Het ene moment vraag ik Claude om een paragraaf te herschrijven, het volgende moment debug ik met ChatGPT, dan geef ik een PDF door aan Gemini." Dat is precies hoe de meesten van ons deze tools gebruiken—pragmatisch, schakelend op basis van wat we op dat moment nodig hebben.

De AI die je de beste resultaten geeft voor je specifieke behoeften—dat is je antwoord. Niet degene met de hoogste benchmark score. Niet degene waar iedereen over praat. Degene die daadwerkelijk voor je werkt.

Wanneer je AI-modellen correct test en vergelijkt, stop je met vertrouwen op hype en begin je te vertrouwen op data uit je eigen ervaring.

Daarom heb ik Zemith gebouwd. Omdat het kiezen van AI-modellen gebaseerd moet zijn op echt testen met echte taken, niet op marketingclaims of theoretische benchmarks.

Probeer meerdere modellen. Vergelijk ze direct. Vind wat werkt. Het is zo simpel.

En eerlijk? Je zou kunnen ontdekken dat het gebruik van meerdere modellen—elk voor wat het het beste doet—beter is dan proberen één model alles te laten doen.

Dat is in ieder geval mijn ervaring geweest. En ik wed dat het ook de jouwe zal zijn zodra je zelf begint te testen.

Wil je AI-modellen op de gemakkelijke manier testen? Bekijk Zemith waar je ChatGPT, Claude, Gemini en meer naast elkaar kunt gebruiken met onze Focus OS-interface. De all-in-one AI-app die je in seconden laat schakelen tussen modelantwoorden met slechts één abonnementsplan

Ontdek Zemith Functies

Introductie van Zemith

De beste tools op één plek, zodat je snel de beste tools voor jouw behoeften kunt gebruiken.

Alles-in-één AI Platform

Ga verder dan AI Chat, met Zoeken, Notities, Beeldgeneratie en meer.

Kostenbesparing

Toegang tot de nieuwste AI-modellen en tools tegen een fractie van de kosten.

Krijg dingen gedaan

Versnel je werk met productiviteits-, werk- en creatieve assistenten.

Constante Updates

Ontvang constante updates met nieuwe functies en verbeteringen om jouw ervaring te verbeteren.

Functies

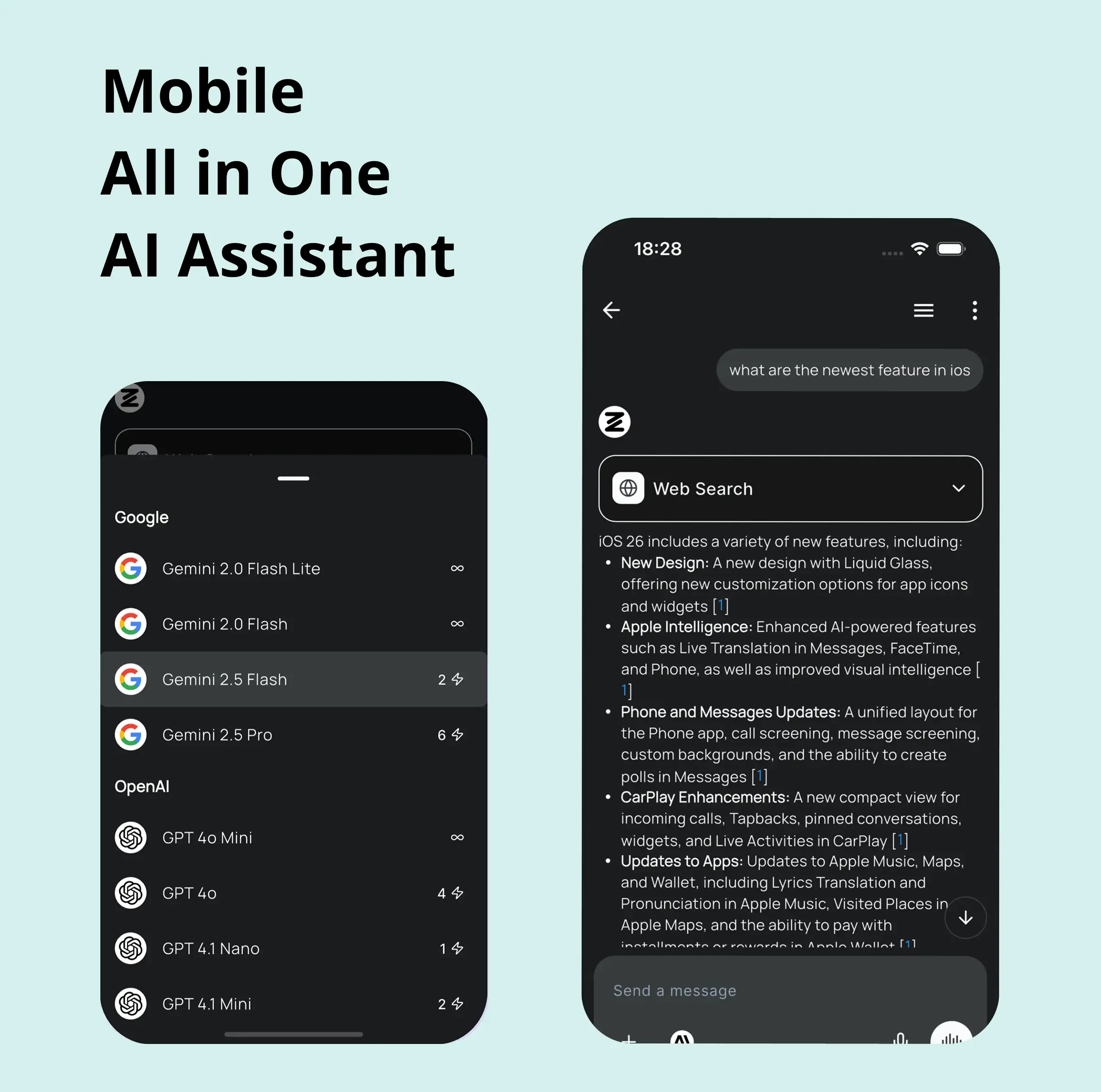

Selectie van Toonaangevende AI Modellen

Toegang tot meerdere geavanceerde AI-modellen op één plek - met Gemini-2.5 Pro, Claude 4.5 Sonnet, GPT 5 en meer om elke taak aan te pakken

Versnel je documenten

Upload documenten naar je Zemith bibliotheek en transformeer ze met AI-aangedreven chat, podcast generatie, samenvattingen en meer

Transformeer je Schrijfproces

Verhoog je notities en documenten met AI-aangedreven assistentie die je helpt sneller, beter en met minder moeite te schrijven

Ontketen je Visuele Creativiteit

Transformeer ideeën in adembenemende visuals met krachtige AI-beeldgeneratie en bewerkingstools die je creatieve visie tot leven brengen

Versnel je Ontwikkelworkflow

Verhoog productiviteit met een AI-codering companion die je helpt code te schrijven, debuggen en optimaliseren in meerdere programmeertalen

Krachtige Tools voor Alledaagse Uitmuntendheid

Stroomlijn je workflow met onze verzameling gespecialiseerde AI-tools ontworpen om veelvoorkomende uitdagingen op te lossen en je productiviteit te verhogen

Live Modus voor Real-time Gesprekken

Spreek natuurlijk, deel je scherm en chat in realtime met AI

AI in je zak

Ervaar de volledige kracht van het Zemith AI-platform, waar je ook bent. Chat met AI, genereer inhoud en verhoog je productiviteit vanaf je mobiele apparaat.

Diep Geïntegreerd met Top AI Modellen

Voorbij basis AI chat - diep geïntegreerde tools en productiviteitsgerichte OS voor maximale efficiëntie

Eenvoudige, betaalbare prijzen

Bespaar uren werk en onderzoek

Betaalbaar plan voor power users

Plus

- 10000 Credits Maandelijks

- Toegang tot plus functies

- Toegang tot Plus Modellen

- Toegang tot tools zoals webzoeken, canvas gebruik, diep onderzoek tool

- Toegang tot Creatieve Functies

- Toegang tot Documentbibliotheek Functies

- Upload tot 50 bronnen per bibliotheekmap

- Toegang tot Aangepast Systeem Prompt

- Toegang tot FocusOS tot 15 tabbladen

- Onbeperkt modelgebruik voor Gemini 2.5 Flash Lite

- Stel Standaard Model In

- Toegang tot Max Modus

- Toegang tot Document naar Podcast

- Toegang tot Document naar Quiz Generator

- Toegang tot on demand credits

- Toegang tot nieuwste functies

Professional

- Alles in Plus, en:

- 21000 Credits Maandelijks

- Toegang tot Pro Modellen

- Toegang tot Pro Functies

- Onbeperkt modelgebruik voor GPT 5 Mini

- Toegang tot code interpreter agent

- Toegang tot automatische tools

- 10000 Credits Maandelijks

- Toegang tot plus functies

- Toegang tot Plus Modellen

- Toegang tot tools zoals webzoeken, canvas gebruik, diep onderzoek tool

- Toegang tot Creatieve Functies

- Toegang tot Documentbibliotheek Functies

- Upload tot 50 bronnen per bibliotheekmap

- Toegang tot Aangepast Systeem Prompt

- Toegang tot FocusOS tot 15 tabbladen

- Onbeperkt modelgebruik voor Gemini 2.5 Flash Lite

- Stel Standaard Model In

- Toegang tot Max Modus

- Toegang tot Document naar Podcast

- Toegang tot Document naar Quiz Generator

- Toegang tot on demand credits

- Toegang tot nieuwste functies

- Alles in Plus, en:

- 21000 Credits Maandelijks

- Toegang tot Pro Modellen

- Toegang tot Pro Functies

- Onbeperkt modelgebruik voor GPT 5 Mini

- Toegang tot code interpreter agent

- Toegang tot automatische tools